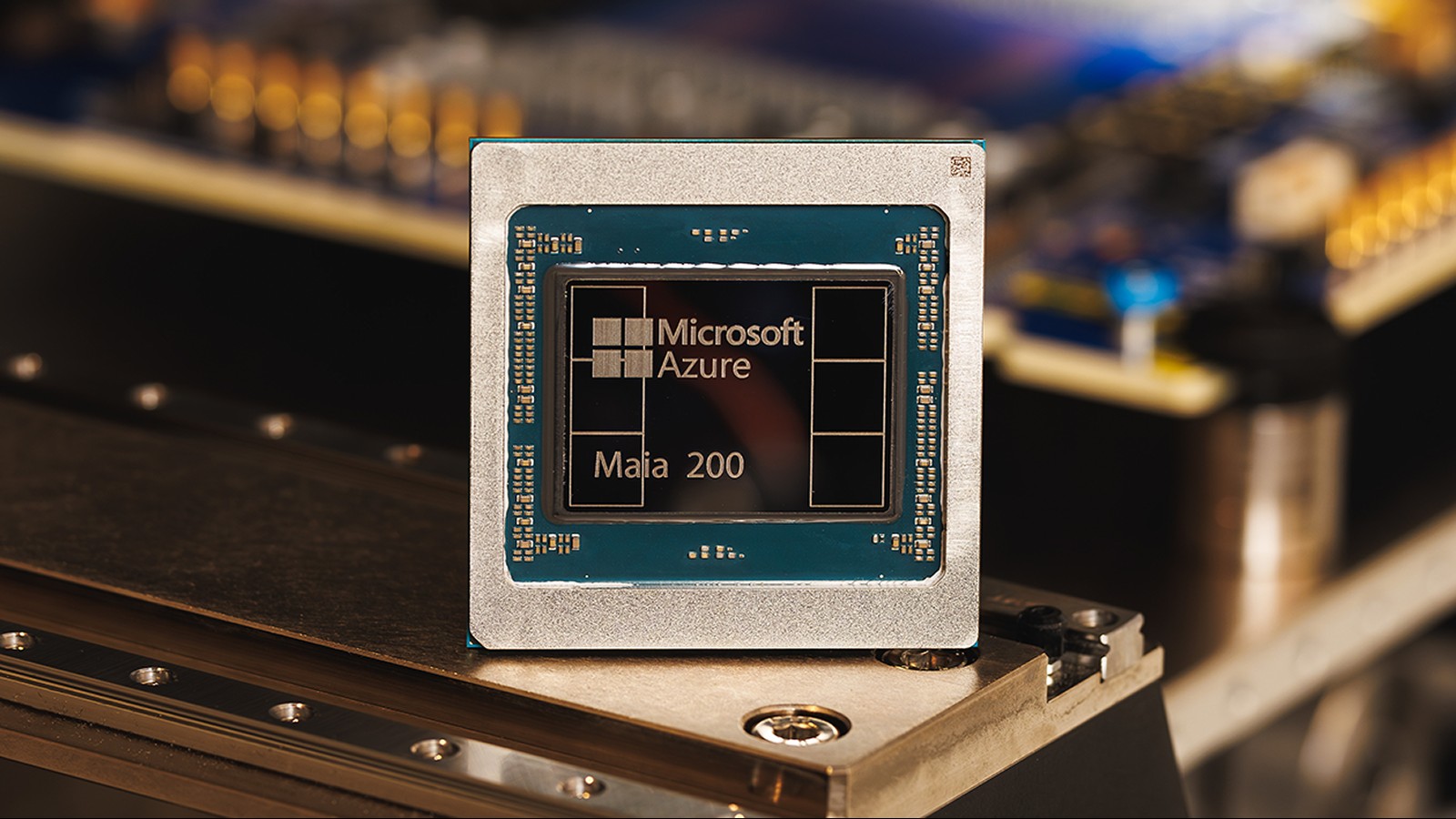

Microsoft представила свій прискорювач Maia 200, заявивши про втричі вищу продуктивність порівняно з конкуруючим обладнанням від Google і Amazon. Це не просто незначне покращення; Це сигналізує про зміну апаратного ландшафту ШІ, особливо в критичній області виведення — процесу використання навчених моделей ШІ для прогнозування та отримання результатів.

Розвиток спеціалізованого обладнання ШІ

Протягом багатьох років компанії покладалися на процесори загального призначення (ЦП) і графічні карти (ГП) для роботи ШІ. Однак у міру того, як моделі ростуть і стають складнішими, необхідні спеціальні чіпи ШІ, такі як Maia 200. Ці чіпи розроблені з нуля для прискорення завдань штучного інтелекту, забезпечуючи значне підвищення швидкості та ефективності.

Maia 200 досягає продуктивності понад 10 петафлопс (10 квадрильйонів операцій з плаваючою комою в секунду), що зазвичай призначається для найпотужніших суперкомп’ютерів у світі. Це досягається за допомогою високо стисненого представлення даних «4-bit precision (FP4)», яке жертвує деякою точністю заради величезного збільшення швидкості. Чіп також забезпечує 5 PFLOPS у дещо менш стиснутому 8-бітовому режимі (FP8).

Внутрішня перевага Microsoft… Наразі

Наразі Microsoft розгортає Maia 200 виключно у своїй хмарній інфраструктурі Azure. Він використовується для генерації синтетичних даних, уточнення моделей наступного покоління (LLM) і потужних служб ШІ, таких як Microsoft Foundry і Copilot. Це дає Microsoft значну перевагу в наданні розширених можливостей ШІ через свою хмарну платформу.

Однак компанія заявила, що незабаром розширить доступність для інших клієнтів, припускаючи, що інші організації незабаром зможуть отримати доступ до живлення Maia 200 через Azure. Чи будуть чіпи врешті-решт продаватися окремо, залишається незрозумілим.

Чому це важливо: ефективність і вартість

Maia 200 – це не просто сирова швидкість. Microsoft стверджує, що забезпечує на 30% кращу продуктивність на долар, ніж існуючі системи, завдяки використанню вдосконаленого 3-нм процесу TSMC. Оскільки кожен чіп містить 100 мільярдів транзисторів, це значний стрибок у щільності та ефективності.

Така економічна ефективність має вирішальне значення, оскільки навчання та експлуатація великих моделей ШІ неймовірно дорогі. Більш потужне апаратне забезпечення означає нижчі експлуатаційні витрати, що робить штучний інтелект доступнішим і стабільнішим.

Наслідки для розробників і кінцевих користувачів

Хоча звичайні користувачі не відразу помітять різницю, підвищення продуктивності зрештою призведе до швидшого часу відгуку та більш розширених функцій у таких інструментах ШІ, як Copilot. Розробники та науковці, які використовують Azure OpenAI, також отримають вигоду від збільшення пропускної здатності та швидкості, прискорюючи дослідження та розробки в таких сферах, як моделювання погоди та вдосконалене моделювання.

Maia 200 представляє стратегічну інвестицію Microsoft, позиціонуючи її як лідера в інфраструктурі ШІ наступного покоління. Хоча наразі це закрита екосистема, потенціал для більшої доступності свідчить про те, що вона може змінити конкурентний ландшафт на ринку хмарних обчислень.

Підсумовуючи, чіп Maia 200 від Microsoft — це не просто чергова частина апаратного забезпечення; це свідчить про зростаючу важливість спеціального прискорення штучного інтелекту та чіткий показник того, у якому напрямку рухається галузь.