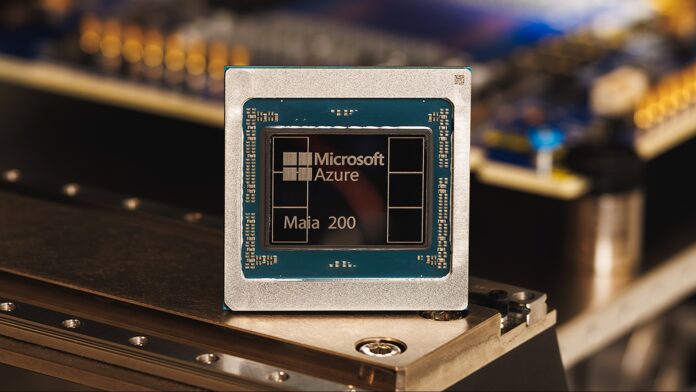

A Microsoft revelou seu chip acelerador Maia 200, afirmando que ele oferece três vezes o desempenho do hardware dos concorrentes do Google e da Amazon. Esta não é apenas uma melhoria marginal; sinaliza uma mudança no cenário do hardware de IA, particularmente na área crucial da inferência – o processo de utilização de modelos de IA treinados para fazer previsões e gerar resultados.

A ascensão do hardware especializado em IA

Durante anos, as empresas confiaram em processadores de uso geral (CPUs) e placas gráficas (GPUs) para potencializar a IA. No entanto, à medida que os modelos se tornam maiores e mais complexos, chips especializados de IA, como o Maia 200, tornam-se essenciais. Esses chips são projetados desde o início para acelerar as tarefas de IA, oferecendo ganhos significativos em velocidade e eficiência.

O Maia 200 atinge mais de 10 petaflops de desempenho (10 quatrilhões de operações de ponto flutuante por segundo), uma métrica normalmente reservada para os supercomputadores mais poderosos do mundo. Isso é possível usando uma representação de dados de “precisão de 4 bits (FP4)” altamente compactada, que sacrifica alguma precisão para ganhos massivos de velocidade. O chip também oferece 5 PFLOPS na precisão de 8 bits um pouco menos compactada (FP8).

Vantagem Interna da Microsoft… Por enquanto

Atualmente, a Microsoft está implantando o Maia 200 exclusivamente em sua própria infraestrutura de nuvem Azure. Ele está sendo usado para gerar dados sintéticos, refinar grandes modelos de linguagem (LLMs) de próxima geração e potencializar serviços de IA como Microsoft Foundry e Copilot. Isto dá à Microsoft uma vantagem substancial no fornecimento de capacidades avançadas de IA através da sua plataforma em nuvem.

No entanto, a empresa indicou que está a chegar uma maior disponibilidade para os clientes, sugerindo que outras organizações poderão em breve aceder à energia do Maia 200 através do Azure. Ainda não se sabe se os chips serão vendidos de forma independente.

Por que isso é importante: eficiência e custo

O Maia 200 não se trata apenas de velocidade bruta. A Microsoft afirma que oferece desempenho 30% melhor por dólar do que os sistemas existentes, graças à sua fabricação usando o processo de 3 nanômetros de última geração da TSMC. Com 100 bilhões de transistores em cada chip, é um salto significativo em densidade e eficiência.

Essa relação custo-benefício é crucial porque o treinamento e a execução de grandes modelos de IA são incrivelmente caros. Um hardware melhor significa custos operacionais mais baixos, tornando a IA mais acessível e sustentável.

Implicações para desenvolvedores e usuários finais

Embora os usuários comuns não percebam imediatamente a diferença, o aumento de desempenho subjacente acabará se traduzindo em tempos de resposta mais rápidos e recursos mais avançados em ferramentas alimentadas por IA, como o Copilot. Os desenvolvedores e cientistas que usam o Azure OpenAI também se beneficiarão de melhores rendimentos e velocidades, acelerando a pesquisa e o desenvolvimento em áreas como modelagem climática e simulações avançadas.

O Maia 200 representa um investimento estratégico da Microsoft, posicionando-a como líder na próxima geração de infraestrutura de IA. Embora seja atualmente um ecossistema fechado, o potencial para uma maior disponibilidade sugere que isto poderia remodelar o cenário competitivo no mercado de computação em nuvem.

Concluindo, o chip Maia 200 da Microsoft não é apenas mais uma peça de hardware; é uma prova da crescente importância da aceleração especializada da IA e um indicador claro do rumo que a indústria está tomando.