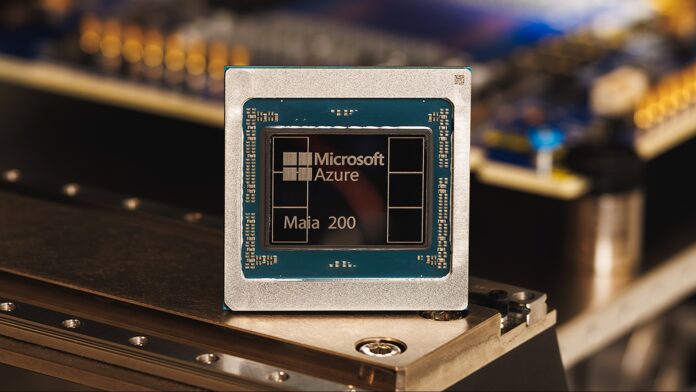

Microsoft zaprezentował swój akcelerator Maia 200, który zapewnia trzykrotnie większą wydajność w porównaniu do konkurencyjnego sprzętu firm Google i Amazon. To nie jest tylko niewielka poprawa; Sygnalizuje to zmianę w krajobrazie sprzętu AI, szczególnie w krytycznym obszarze wnioskowania — procesu wykorzystywania wytrenowanych modeli sztucznej inteligencji do przewidywania i generowania wyników.

Powstanie wyspecjalizowanego sprzętu AI

Od lat firmy polegają na jednostkach przetwarzających ogólnego przeznaczenia (CPU) i kartach graficznych (GPU) do zasilania sztucznej inteligencji. Jednak w miarę rozrastania się i zwiększania złożoności modeli niezbędne stają się wyspecjalizowane chipy AI, takie jak Maia 200. Chipy te zostały zaprojektowane od podstaw w celu przyspieszenia zadań AI, zapewniając znaczny wzrost szybkości i wydajności.

Maia 200 osiąga wydajność przekraczającą 10 petaflopów (10 biliardów operacji zmiennoprzecinkowych na sekundę), czyli wydajność zwykle zarezerwowaną dla najpotężniejszych superkomputerów na świecie. Osiąga się to poprzez zastosowanie wysoce skompresowanej reprezentacji danych o „4-bitowej precyzji (FP4)”, która poświęca pewną precyzję na rzecz ogromnego przyrostu prędkości. Układ zapewnia również 5 PFLOPS przy nieco mniej skompresowanej 8-bitowej precyzji (FP8).

Wewnętrzna przewaga Microsoftu… Na razie

Microsoft wdraża obecnie Maia 200 wyłącznie w swojej infrastrukturze chmurowej Azure. Służy do generowania danych syntetycznych, udoskonalania modeli nowej generacji (LLM) i zasilania usług AI, takich jak Microsoft Foundry i Copilot. Daje to firmie Microsoft znaczną przewagę w dostarczaniu zaawansowanych możliwości sztucznej inteligencji za pośrednictwem platformy chmurowej.

Firma stwierdziła jednak, że wkrótce rozszerzy dostępność dla innych klientów, co sugeruje, że inne organizacje wkrótce będą mogły uzyskać dostęp do mocy Maia 200 za pośrednictwem platformy Azure. Nie jest jasne, czy chipy będą ostatecznie sprzedawane osobno.

Dlaczego to ma znaczenie: wydajność i koszt

Maia 200 to nie tylko czysta prędkość. Microsoft twierdzi, że zapewnia 30% lepszą wydajność w przeliczeniu na dolara niż istniejące systemy dzięki produkcji z wykorzystaniem zaawansowanego procesu 3 nm firmy TSMC. Dzięki 100 miliardom tranzystorów umieszczonych w każdym chipie jest to znaczący skok w gęstości i wydajności.

Ta efektywność kosztowa ma kluczowe znaczenie, ponieważ duże modele sztucznej inteligencji są niezwykle drogie w szkoleniu i obsłudze. Mocniejszy sprzęt oznacza niższe koszty operacyjne, dzięki czemu sztuczna inteligencja jest bardziej przystępna cenowo i zrównoważona.

Konsekwencje dla programistów i użytkowników końcowych

Chociaż zwykli użytkownicy nie zauważą różnicy od razu, zwiększona wydajność ostatecznie doprowadzi do krótszego czasu reakcji i bardziej zaawansowanych funkcji narzędzi AI, takich jak Copilot. Deweloperzy i naukowcy korzystający z Azure OpenAI również skorzystają na zwiększonej przepustowości i szybkości, przyspieszając badania i rozwój w takich obszarach, jak modelowanie pogody i zaawansowana symulacja.

Maia 200 stanowi strategiczną inwestycję firmy Microsoft, pozycjonującą ją jako lidera infrastruktury sztucznej inteligencji nowej generacji. Chociaż jest to obecnie zamknięty ekosystem, potencjał szerszej dostępności sugeruje, że może zmienić krajobraz konkurencyjny na rynku przetwarzania w chmurze.

Podsumowując, chip Maia 200 firmy Microsoft to nie tylko kolejny element sprzętu; świadczy to o rosnącym znaczeniu dedykowanej akceleracji AI i wyraźnym wskaźnikiem kierunku, w jakim zmierza branża.