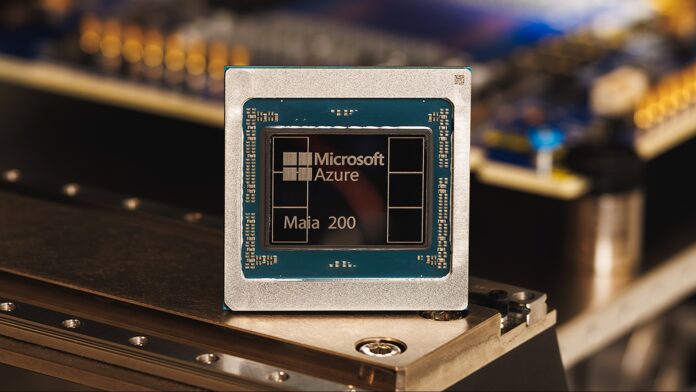

Microsoft heeft zijn Maia 200-acceleratorchip onthuld en beweert dat deze driemaal de prestaties levert van de hardware van concurrenten van Google en Amazon. Dit is niet slechts een marginale verbetering; het signaleert een verschuiving in het AI-hardwarelandschap, vooral op het cruciale gebied van inferentie – het proces waarbij getrainde AI-modellen worden gebruikt om voorspellingen te doen en resultaten te genereren.

De opkomst van gespecialiseerde AI-hardware

Bedrijven vertrouwen al jaren op algemene processors (CPU’s) en grafische kaarten (GPU’s) om AI aan te drijven. Naarmate modellen echter groter en complexer worden, worden gespecialiseerde AI-chips zoals Maia 200 essentieel. Deze chips zijn vanaf de basis ontworpen om AI-taken te versnellen en aanzienlijke winsten in snelheid en efficiëntie te bieden.

De Maia 200 behaalt meer dan 10 petaflops aan prestaties (10 biljard drijvende-kommabewerkingen per seconde), een maatstaf die doorgaans gereserveerd is voor de krachtigste supercomputers ter wereld. Dit wordt mogelijk gemaakt door gebruik te maken van een sterk gecomprimeerde “4-bit precisie (FP4)” datarepresentatie, die enige nauwkeurigheid opoffert voor enorme snelheidswinsten. De chip levert ook 5 PFLOPS in de iets minder gecomprimeerde 8-bit precisie (FP8).

Het interne voordeel van Microsoft… Voorlopig

Momenteel implementeert Microsoft Maia 200 exclusief binnen zijn eigen Azure-cloudinfrastructuur. Het wordt gebruikt om synthetische gegevens te genereren, grote taalmodellen (LLM’s) van de volgende generatie te verfijnen en AI-services zoals Microsoft Foundry en Copilot aan te sturen. Dit geeft Microsoft een aanzienlijke voorsprong bij het bieden van geavanceerde AI-mogelijkheden via zijn cloudplatform.

Het bedrijf heeft echter aangegeven dat er een grotere beschikbaarheid voor klanten op komst is, wat erop wijst dat andere organisaties binnenkort via Azure toegang zullen kunnen krijgen tot de stroom van Maia 200. Of de chips uiteindelijk zelfstandig verkocht zullen worden, valt nog te bezien.

Waarom dit belangrijk is: efficiëntie en kosten

Bij de Maia 200 draait het niet alleen om pure snelheid. Microsoft beweert dat het 30% betere prestaties per dollar levert dan bestaande systemen, dankzij de fabricage met behulp van het geavanceerde 3-nanometerproces van TSMC. Met 100 miljard transistors op elke chip is dit een aanzienlijke sprong in dichtheid en efficiëntie.

Deze kosteneffectiviteit is cruciaal omdat het trainen en uitvoeren van grote AI-modellen ongelooflijk duur is. Betere hardware betekent lagere operationele kosten, waardoor AI toegankelijker en duurzamer wordt.

Implicaties voor ontwikkelaars en eindgebruikers

Hoewel gewone gebruikers niet meteen een verschil zullen merken, zal de onderliggende prestatieverbetering zich uiteindelijk vertalen in snellere responstijden en meer geavanceerde functies in AI-aangedreven tools zoals Copilot. Ontwikkelaars en wetenschappers die Azure OpenAI gebruiken, zullen ook profiteren van verbeterde doorvoer en snelheden, waardoor onderzoek en ontwikkeling op gebieden als weermodellering en geavanceerde simulaties worden versneld.

De Maia 200 vertegenwoordigt een strategische investering van Microsoft en positioneert hen als leider in de volgende generatie AI-infrastructuur. Hoewel het momenteel een gesloten ecosysteem is, suggereert het potentieel voor bredere beschikbaarheid dat dit het concurrentielandschap op de cloud computing-markt zou kunnen hervormen.

Kortom, de Maia 200-chip van Microsoft is niet zomaar een stukje hardware; het is een bewijs van het groeiende belang van gespecialiseerde AI-versnelling en een duidelijke indicatie van waar de industrie naartoe gaat.