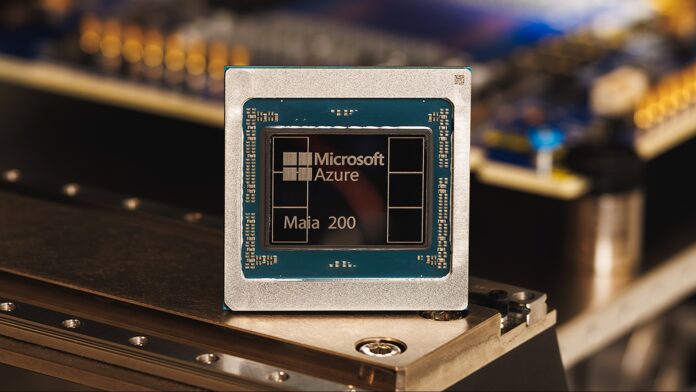

Microsoft ha presentato il suo chip acceleratore Maia 200, affermando che offre tre volte le prestazioni dell’hardware della concorrenza di Google e Amazon. Questo non è solo un miglioramento marginale; segnala un cambiamento nel panorama dell’hardware dell’intelligenza artificiale, in particolare nell’area cruciale dell’inferenza – il processo di utilizzo di modelli di intelligenza artificiale addestrati per fare previsioni e generare risultati.

L’ascesa dell’hardware IA specializzato

Per anni, le aziende si sono affidate a processori generici (CPU) e schede grafiche (GPU) per potenziare l’intelligenza artificiale. Tuttavia, man mano che i modelli diventano più grandi e complessi, i chip AI specializzati come Maia 200 stanno diventando essenziali. Questi chip sono progettati da zero per accelerare le attività di intelligenza artificiale, offrendo vantaggi significativi in termini di velocità ed efficienza.

Maia 200 raggiunge oltre 10 petaflop di prestazioni (10 quadrilioni di operazioni in virgola mobile al secondo), un parametro tipicamente riservato ai supercomputer più potenti del mondo. Ciò è possibile utilizzando una rappresentazione dei dati “precisione a 4 bit (FP4)” altamente compressa, che sacrifica una certa precisione per enormi guadagni di velocità. Il chip fornisce anche 5 PFLOPS con precisione a 8 bit leggermente meno compressa (FP8).

Vantaggio interno di Microsoft… Per ora

Attualmente, Microsoft sta distribuendo Maia 200 esclusivamente all’interno della propria infrastruttura cloud di Azure. Viene utilizzato per generare dati sintetici, perfezionare modelli linguistici di grandi dimensioni (LLM) di prossima generazione e potenziare servizi di intelligenza artificiale come Microsoft Foundry e Copilot. Ciò offre a Microsoft un vantaggio sostanziale nel fornire funzionalità di intelligenza artificiale avanzate attraverso la sua piattaforma cloud.

Tuttavia, la società ha indicato che è in arrivo una maggiore disponibilità da parte dei clienti, suggerendo che altre organizzazioni saranno presto in grado di accedere alla potenza di Maia 200 tramite Azure. Resta da vedere se i chip verranno eventualmente venduti singolarmente.

Perché è importante: efficienza e costi

Maia 200 non è solo pura velocità. Microsoft afferma che offre prestazioni migliori del 30% per dollaro rispetto ai sistemi esistenti, grazie alla sua fabbricazione utilizzando il processo all’avanguardia a 3 nanometri di TSMC. Con 100 miliardi di transistor racchiusi in ciascun chip, si tratta di un salto significativo in termini di densità ed efficienza.

Questo rapporto costo-efficacia è fondamentale perché la formazione e l’esecuzione di modelli di intelligenza artificiale di grandi dimensioni sono incredibilmente costose. Un hardware migliore significa costi operativi inferiori, rendendo l’intelligenza artificiale più accessibile e sostenibile.

Implicazioni per sviluppatori e utenti finali

Sebbene gli utenti di tutti i giorni non noteranno immediatamente una differenza, l’aumento delle prestazioni di fondo si tradurrà alla fine in tempi di risposta più rapidi e funzionalità più avanzate in strumenti basati sull’intelligenza artificiale come Copilot. Gli sviluppatori e gli scienziati che utilizzano Azure OpenAI beneficeranno inoltre di throughput e velocità migliorati, accelerando la ricerca e lo sviluppo in aree quali la modellazione meteorologica e le simulazioni avanzate.

Maia 200 rappresenta un investimento strategico da parte di Microsoft, posizionandola come leader nella prossima generazione di infrastrutture AI. Sebbene attualmente si tratti di un ecosistema chiuso, il potenziale per una disponibilità più ampia suggerisce che ciò potrebbe rimodellare il panorama competitivo nel mercato del cloud computing.

In conclusione, il chip Maia 200 di Microsoft non è solo un altro componente hardware; è una testimonianza della crescente importanza dell’accelerazione specializzata dell’intelligenza artificiale e un chiaro indicatore della direzione in cui si sta dirigendo il settore.