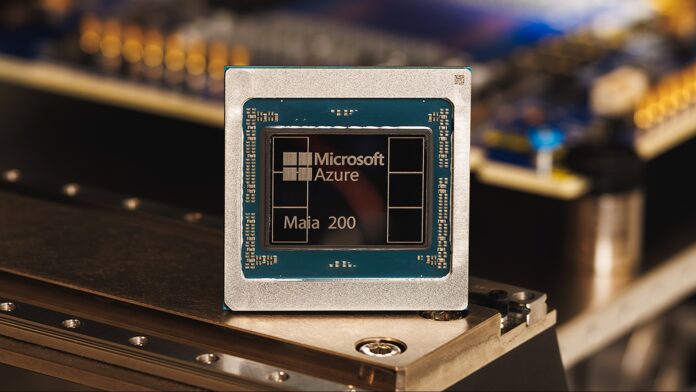

Microsoft telah meluncurkan chip akselerator Maia 200, dengan menyatakan bahwa chip tersebut memberikan kinerja tiga kali lipat dibandingkan perangkat keras pesaing dari Google dan Amazon. Ini bukan sekedar perbaikan kecil; Hal ini menandakan adanya pergeseran dalam lanskap perangkat keras AI, khususnya di bidang penting inferensi – proses penggunaan model AI terlatih untuk membuat prediksi dan menghasilkan keluaran.

Bangkitnya Perangkat Keras AI Khusus

Selama bertahun-tahun, perusahaan mengandalkan prosesor serba guna (CPU) dan kartu grafis (GPU) untuk mendukung AI. Namun, seiring dengan pertumbuhan model yang semakin besar dan kompleks, chip AI khusus seperti Maia 200 menjadi semakin penting. Chip ini dirancang sejak awal untuk mempercepat tugas-tugas AI, menawarkan peningkatan kecepatan dan efisiensi yang signifikan.

Maia 200 mencapai kinerja lebih dari 10 petaflops (10 kuadriliun operasi floating-point per detik), sebuah metrik yang biasanya diperuntukkan bagi superkomputer paling kuat di dunia. Hal ini dimungkinkan dengan menggunakan representasi data “presisi 4-bit (FP4)” yang sangat terkompresi, yang mengorbankan sejumlah akurasi demi peningkatan kecepatan yang sangat besar. Chip ini juga menghasilkan 5 PFLOPS dalam presisi 8-bit (FP8) yang sedikit lebih sedikit terkompresi.

Keunggulan Internal Microsoft… Untuk Saat Ini

Saat ini, Microsoft menerapkan Maia 200 secara eksklusif dalam infrastruktur cloud Azure miliknya. Ini digunakan untuk menghasilkan data sintetis, menyempurnakan model bahasa besar (LLM) generasi berikutnya, dan mendukung layanan AI seperti Microsoft Foundry dan Copilot. Hal ini memberi Microsoft keunggulan besar dalam menyediakan kemampuan AI tingkat lanjut melalui platform cloud-nya.

Namun, perusahaan telah mengindikasikan bahwa ketersediaan pelanggan yang lebih luas akan datang, yang menunjukkan bahwa organisasi lain akan segera dapat mengakses kekuatan Maia 200 melalui Azure. Apakah chip tersebut pada akhirnya akan dijual secara mandiri masih harus dilihat.

Mengapa Ini Penting: Efisiensi dan Biaya

Maia 200 bukan hanya tentang kecepatan mentah. Microsoft mengklaim sistem ini memberikan kinerja 30% lebih baik per dolar dibandingkan sistem yang sudah ada, berkat fabrikasinya menggunakan proses 3-nanometer mutakhir TSMC. Dengan 100 miliar transistor yang dikemas dalam setiap chip, ini merupakan lompatan signifikan dalam hal kepadatan dan efisiensi.

Efektivitas biaya ini sangat penting karena pelatihan dan pengoperasian model AI berukuran besar sangatlah mahal. Perangkat keras yang lebih baik berarti biaya operasional yang lebih rendah, menjadikan AI lebih mudah diakses dan berkelanjutan.

Implikasinya bagi Pengembang dan Pengguna Akhir

Meskipun pengguna sehari-hari tidak akan langsung menyadari perbedaannya, peningkatan kinerja yang mendasarinya pada akhirnya akan menghasilkan waktu respons yang lebih cepat dan fitur yang lebih canggih pada alat yang didukung AI seperti Copilot. Pengembang dan ilmuwan yang menggunakan Azure OpenAI juga akan mendapatkan keuntungan dari peningkatan throughput dan kecepatan, mempercepat penelitian dan pengembangan di berbagai bidang seperti pemodelan cuaca dan simulasi tingkat lanjut.

Maia 200 mewakili investasi strategis Microsoft, yang memposisikan mereka sebagai pemimpin dalam infrastruktur AI generasi berikutnya. Meskipun saat ini ekosistemnya tertutup, potensi ketersediaan yang lebih luas menunjukkan bahwa hal ini dapat mengubah lanskap persaingan di pasar komputasi awan.

Kesimpulannya, chip Maia 200 Microsoft bukan sekadar perangkat keras; Hal ini merupakan bukti semakin pentingnya akselerasi AI khusus dan indikator yang jelas mengenai arah industri ini.