Durante más de 100 años, los astrónomos se han enfrentado a una pregunta fundamental: ¿a qué velocidad se está expandiendo el universo? Este debate duradero, a menudo llamado “el gran debate de la cosmología”, comenzó en la década de 1920 y continúa hoy, no por falta de datos, sino por mediciones contradictorias y la posible necesidad de una física completamente nueva.

El primer gran debate: galaxias más allá de la nuestra

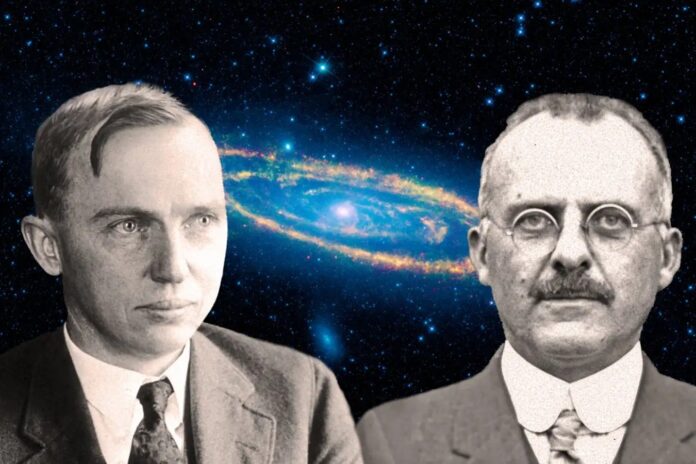

El choque inicial surgió de una simple pregunta: ¿las débiles “nebulosas espirales” observadas en el cielo nocturno eran simplemente nubes dentro de nuestra propia galaxia, la Vía Láctea, o eran galaxias completamente separadas más allá de la nuestra? En 1920, Harlow Shapley y Heber Curtis entablaron un debate público en la Academia Nacional de Ciencias de Estados Unidos, en el que Shapley defendía un universo relativamente pequeño dominado por la Vía Láctea. Curtis respondió que estas nebulosas eran “universos insulares”, galaxias independientes a grandes distancias.

Se demostró que Curtis tenía razón cuando Edwin Hubble confirmó más tarde que estas nebulosas eran, de hecho, galaxias más allá de la nuestra. Este descubrimiento amplió drásticamente la escala conocida del universo, pasando de una visión localizada a una de inmensidad cósmica. Sin embargo, incluso después de esta resolución, el debate sobre cuán rápidamente se estaba expandiendo el universo apenas había comenzado.

La constante de Hubble y las primeras discrepancias

El propio Hubble propuso la “constante de Hubble” en 1929, un número que cuantifica la tasa de expansión cósmica. Su estimación inicial era de unos 500 kilómetros por segundo por megaparsec, lo que implica un universo joven. Sin embargo, este valor presentó inmediatamente una paradoja: de ser cierto, el universo sería más joven que algunas de las rocas más antiguas de la Tierra, lo cual era imposible.

En la década de 1980, los astrónomos se dividieron en dos bandos opuestos: Gérard de Vaucouleurs, que favorecía una constante de Hubble cercana a 100, y Allan Sandage, que abogaba por un valor más bajo, alrededor de 50. Ambos utilizaron métodos similares pero se negaron obstinadamente a ceder terreno.

El proyecto clave del Hubble y el conflicto renovado

El lanzamiento del Telescopio Espacial Hubble en la década de 1990 aportó una nueva precisión. Wendy Freedman dirigió el “Proyecto Hubble Key”, refinando las mediciones a un valor de aproximadamente 72 kilómetros por segundo por megaparsec. Durante un tiempo, pareció que el debate estaba resuelto y los datos convergentes apuntaban hacia esta cifra.

Sin embargo, a principios de la década de 2000 surgió un nuevo conflicto. Las mediciones basadas en el fondo cósmico de microondas (CMB), el resplandor del Big Bang, arrojaron un valor significativamente más bajo: alrededor de 67 kilómetros por segundo por megaparsec. Esta discrepancia, conocida como la “tensión del Hubble”, ha persistido a pesar de mediciones cada vez más precisas en ambos lados.

El gran debate moderno: un misterio más profundo

Hoy en día, la tensión del Hubble sigue sin resolverse. Los dos métodos, las mediciones de distancia local y el análisis CMB, siguen sin estar de acuerdo. Esto sugiere varias posibilidades: errores sistemáticos en uno o ambos métodos, o la necesidad de una física completamente nueva más allá de nuestra comprensión actual del universo.

Los astrónomos ahora están explorando métodos independientes, como el análisis de ondas de gravedad y el uso de diferentes tipos de estrellas para refinar las mediciones. El debate continúa, no como una simple cuestión de desacuerdo, sino como una señal de que nuestra comprensión fundamental del cosmos aún puede ser incompleta.

La búsqueda en curso para medir la expansión del universo no es simplemente un ejercicio académico; es una búsqueda de la imagen más precisa de la realidad misma. La persistencia de la tensión de Hubble sugiere que el universo puede contener sorpresas mucho más allá de lo que imaginamos actualmente.