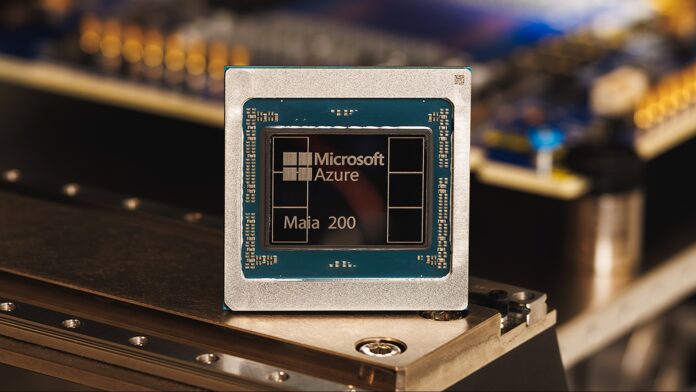

Microsoft hat seinen Beschleunigerchip Maia 200 vorgestellt und behauptet, er biete dreimal so viel Leistung wie die Hardware der Konkurrenz von Google und Amazon. Dies ist nicht nur eine geringfügige Verbesserung; Es signalisiert einen Wandel in der KI-Hardwarelandschaft, insbesondere im entscheidenden Bereich der Inferenz – dem Prozess der Verwendung trainierter KI-Modelle, um Vorhersagen zu treffen und Ergebnisse zu generieren.

Der Aufstieg spezialisierter KI-Hardware

Seit Jahren verlassen sich Unternehmen für die KI auf Allzweckprozessoren (CPUs) und Grafikkarten (GPUs). Da die Modelle jedoch immer größer und komplexer werden, werden spezielle KI-Chips wie der Maia 200 immer wichtiger. Diese Chips sind von Grund auf darauf ausgelegt, KI-Aufgaben zu beschleunigen und bieten erhebliche Geschwindigkeits- und Effizienzgewinne.

Der Maia 200 erreicht eine Leistung von über 10 Petaflops (10 Billiarden Gleitkommaoperationen pro Sekunde), eine Kennzahl, die normalerweise den leistungsstärksten Supercomputern der Welt vorbehalten ist. Dies wird durch die Verwendung einer stark komprimierten Datendarstellung mit „4-Bit-Präzision (FP4)“ ermöglicht, die für enorme Geschwindigkeitsgewinne etwas Genauigkeit opfert. Der Chip liefert auch 5 PFLOPS in der etwas weniger komprimierten 8-Bit-Präzision (FP8).

Microsofts interner Vorteil… vorerst

Derzeit stellt Microsoft Maia 200 ausschließlich innerhalb seiner eigenen Azure-Cloud-Infrastruktur bereit. Es wird verwendet, um synthetische Daten zu generieren, große Sprachmodelle (LLMs) der nächsten Generation zu verfeinern und KI-Dienste wie Microsoft Foundry und Copilot zu betreiben. Dies verschafft Microsoft einen erheblichen Vorsprung bei der Bereitstellung fortschrittlicher KI-Funktionen über seine Cloud-Plattform.

Das Unternehmen hat jedoch angedeutet, dass die Kundenverfügbarkeit bald zunehmen wird, was darauf hindeutet, dass andere Organisationen bald über Azure auf die Leistung von Maia 200 zugreifen können. Ob die Chips irgendwann einzeln verkauft werden, bleibt abzuwarten.

Warum das wichtig ist: Effizienz und Kosten

Beim Maia 200 geht es nicht nur um pure Geschwindigkeit. Microsoft behauptet, dass es dank der Herstellung im hochmodernen 3-Nanometer-Prozess von TSMC eine um 30 % bessere Leistung pro Dollar liefert als bestehende Systeme. Mit 100 Milliarden Transistoren auf jedem Chip ist dies ein erheblicher Sprung in puncto Dichte und Effizienz.

Diese Kosteneffizienz ist von entscheidender Bedeutung, da das Training und der Betrieb großer KI-Modelle unglaublich teuer sind. Bessere Hardware bedeutet niedrigere Betriebskosten und macht KI zugänglicher und nachhaltiger.

Auswirkungen für Entwickler und Endbenutzer

Während normale Benutzer nicht sofort einen Unterschied bemerken, wird sich die zugrunde liegende Leistungssteigerung letztendlich in schnelleren Reaktionszeiten und erweiterten Funktionen in KI-gestützten Tools wie Copilot niederschlagen. Entwickler und Wissenschaftler, die Azure OpenAI verwenden, profitieren außerdem von einem verbesserten Durchsatz und einer höheren Geschwindigkeit, wodurch Forschung und Entwicklung in Bereichen wie Wettermodellierung und erweiterten Simulationen beschleunigt werden.

Der Maia 200 stellt eine strategische Investition von Microsoft dar und positioniert das Unternehmen als Marktführer in der nächsten Generation der KI-Infrastruktur. Obwohl es sich derzeit um ein geschlossenes Ökosystem handelt, deutet das Potenzial für eine breitere Verfügbarkeit darauf hin, dass dies die Wettbewerbslandschaft auf dem Cloud-Computing-Markt verändern könnte.

Zusammenfassend lässt sich sagen, dass der Maia 200-Chip von Microsoft nicht nur ein weiteres Stück Hardware ist; Dies ist ein Beweis für die wachsende Bedeutung der spezialisierten KI-Beschleunigung und ein klarer Indikator dafür, wohin sich die Branche entwickelt.